- 1. Основные принципы индексации сайта

- 2. Краулинг: как поисковые системы сканируют ваш сайт

- 2.1. Работа роботов поисковых систем

- 2.2. Управление доступом краулеров к сайту

- 2.3. Примеры использования файла robots.txt

- 2.4. Примеры использования мета-тегов

- 3. Архитектура сайта и ее роль в техническом SEO

- 4. Инструменты и практики для анализа и улучшения технического SEO

Индексация, краулинг и архитектура сайта

Технический SEO является неотъемлемой частью процесса оптимизации веб-сайтов, направленной на улучшение их видимости в поисковых системах. Этот аспект SEO фокусируется на оптимизации структуры сайта, его индексации и краулинге, чтобы обеспечить его доступность и понимание поисковыми системами. Важность технического SEO нельзя недооценивать, поскольку он лежит в основе успешности всей стратегии продвижения в интернете, влияя на скорость загрузки страниц, мобильную оптимизацию, безопасность сайта и его архитектуру.

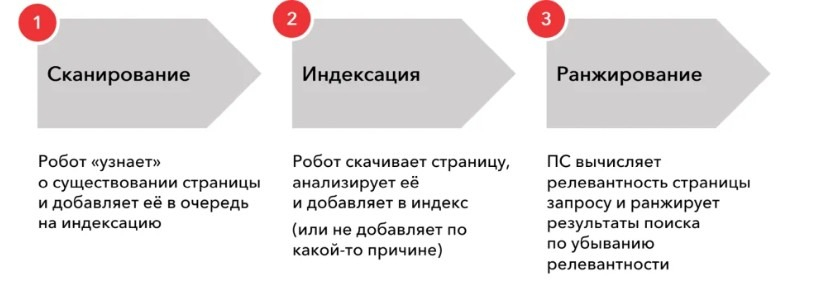

Алгоритм работы поисковой системы

Алгоритм работы поисковой системы

Основные принципы индексации сайта

Основные понятия, такие как индексация, краулинг и архитектура сайта, играют ключевую роль в техническом SEO. Индексация означает процесс добавления страниц сайта в базу данных поисковой системы, что делает их доступными для поиска пользователями.

Краулинг - это процесс сканирования сайта поисковыми роботами для обновления и индексации его содержимого. Архитектура сайта влияет на то, насколько легко поисковым системам и пользователям находить содержимое на сайте, а также на общую пользовательскую восприимчивость и удобство использования.

Значение технического SEO заключается в том, что без правильной технической оптимизации сайта даже самый качественный и полезный контент может остаться незамеченным поисковыми системами и пользователями. Технические аспекты сайта должны быть оптимизированы таким образом, чтобы обеспечить максимальную доступность и эффективность его индексации и краулинга, что в конечном итоге приводит к улучшению позиций в поисковой выдаче и увеличению трафика.

Понятие индексации и ее важность для SEO

Индексация веб-сайта – это процесс, при котором поисковые системы собирают, анализируют и хранят данные для быстрого предоставления релевантной информации пользователям. Этот процесс позволяет страницам сайта появляться в поисковой выдаче в ответ на запросы пользователей. Важность индексации для SEO сложно переоценить, поскольку без корректной индексации страницы сайта не будут показываться в результатах поиска, что напрямую влияет на видимость сайта, его трафик и, как следствие, коммерческую успешность. Оптимизация индексации является критически важной задачей для вебмастеров и SEO-специалистов, стремящихся улучшить позиции сайта в поисковой выдаче и привлечь целевую аудиторию.

Оптимизация сайта для улучшения индексации

Оптимизация сайта с целью улучшения индексации включает в себя ряд технических улучшений и модификаций, направленных на обеспечение беспрепятственного доступа поисковых роботов к содержимому сайта. Ключевые аспекты оптимизации включают улучшение структуры URL, использование файла robots.txt для управления доступом краулеров, создание и оптимизация XML-карты сайта для облегчения процесса краулинга. Кроме того, важно уделять внимание устранению дублирующегося контента, оптимизации скорости загрузки страниц и обеспечению адаптации сайта под мобильные устройства. Все эти меры направлены на то, чтобы сделать сайт более "прозрачным" и доступным для поисковых систем, что в свою очередь способствует повышению ранжирования и увеличению видимости сайта в поисковых системах.

Краулинг: как поисковые системы сканируют ваш сайт

Краулинг

Краулинг

Краулинг – это процесс, при котором поисковые роботы (или краулеры) систематически просматривают интернет для обновления своих баз данных с новым и измененным контентом. Для веб-сайтов это означает возможность быть найденным и проиндексированным. Поисковые системы используют сложные алгоритмы для определения, как и когда сайты будут сканироваться, учитывая такие факторы, как частота обновления контента на сайте, количество и качество внешних ссылок, указывающих на сайт, а также техническую доступность страниц для краулинга.

Работа роботов поисковых систем

Роботы поисковых систем, такие как Googlebot (Google), Bingbot (Bing) и другие, начинают свою работу с известных URL-адресов, полученных в результате предыдущих краулингов, и переходят по ссылкам на этих страницах для обнаружения новых URL-ов. Этот процесс помогает им обнаружить обновленный или новый контент для индексации. Важно, чтобы сайт был правильно настроен для обеспечения эффективного доступа краулеров, включая правильное использование структуры URL, файлов robots.txt и редиректов.

Управление доступом краулеров к сайту

Управление доступом краулеров к вашему сайту может быть осуществлено с помощью файла robots.txt, который указывает поисковым системам, какие страницы или разделы сайта следует сканировать, а какие – нет. Например, если вы не хотите, чтобы определенные страницы были проиндексированы (например, страницы с личной информацией или временным контентом), вы можете указать это в файле robots.txt. Также важно использовать мета-теги, такие как "noindex" и "nofollow", для управления индексацией на уровне отдельных страниц и ссылок.

Примеры использования файла robots.txt

Запрет индексации всего сайта

plaintextCopy code

User-agent: * Disallow: /

Этот пример полностью исключает сайт из краулинга поисковыми системами, полезно для сайтов в разработке или тестовых сред.

Разрешение индексации только определенного раздела

plaintextCopy code

User-agent: * Disallow: / Allow: /public-section/

Здесь инструкция Disallow: / блокирует доступ ко всему сайту, но Allow: /public-section/ разрешает индексацию только содержимого в разделе /public-section/.

Исключение определенных файлов по расширению

plaintextCopy code

User-agent: * Disallow: /*.pdf$

В этом примере запрещается индексация всех файлов с расширением .pdf на сайте, что может быть полезно для предотвращения индексации больших объемов неоптимизированного или конфиденциального контента.

Примеры использования мета-тегов

Запрет индексации конкретной страницы

В HTML код страницы добавляется следующий мета-тег в секции <head>:

htmlCopy code

<meta name="robots" content="noindex">

Этот тег сообщает поисковым системам не индексировать данную страницу.

Запрет следования по ссылкам на странице

htmlCopy code

<meta name="robots" content="nofollow">

С этим тегом поисковые системы могут индексировать страницу, но не будут следовать по ссылкам на ней.

Пример настройки ответов сервера

Ответ 301 (постоянное перенаправление)

Если контент перемещен на новый URL, сервер может отправить статус 301, чтобы сообщить поисковым системам о постоянном перенаправлении на новый адрес. Это помогает сохранить ценность ссылочного веса и улучшить индексацию.

vbnetCopy code

HTTP/1.1 301 Moved Permanently Location: https://example.com/new-page.html

Ответ 404 (страница не найдена) или 410 (страница удалена)

Для страниц, которые были удалены и не должны индексироваться, важно убедиться, что сервер возвращает статус 404 или 410. Это сигнализирует поисковым системам, что содержимое больше не существует и его следует удалить из индекса.

mathematicaCopy code

HTTP/1.1 404 Not Found

или

Copy code

HTTP/1.1 410 Gone

Эти примеры демонстрируют различные способы управления доступом краулеров к вашему сайту и его контенту, что является важной частью технической оптимизации для поисковых систем.

Архитектура сайта и ее роль в техническом SEO

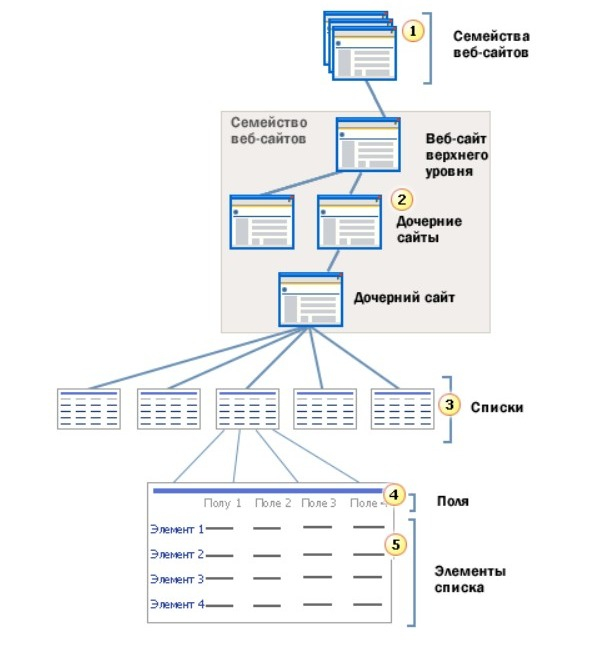

Обзор архитектуры сайта и объектной модели

Обзор архитектуры сайта и объектной модели

Архитектура сайта играет ключевую роль в техническом SEO, обеспечивая основу для эффективной индексации и удобства использования. Она влияет на то, как поисковые системы понимают и ранжируют сайт, а также на общий пользовательский опыт. Рассмотрим два основных аспекта архитектуры сайта: создание логической структуры сайта и внутреннюю перелинковку с навигацией.

Создание логической структуры сайта

Логическая структура сайта должна быть интуитивно понятной как для пользователей, так и для поисковых систем. Она включает в себя организацию контента по категориям и подкатегориям, что упрощает навигацию и помогает поисковым системам лучше понимать иерархию и взаимосвязь между страницами.

- Иерархическая структура. Страницы организованы в иерархию от самых общих категорий до более специфических подкатегорий. Это помогает пользователям и поисковым системам легко находить информацию.

- Плоская архитектура. Стремятся минимизировать количество кликов, необходимых для перехода от главной страницы к любому контенту. Это улучшает доступность контента для краулеров и улучшает пользовательский опыт.

Внутренняя перелинковка и навигация

Внутренняя перелинковка относится к процессу создания ссылок между страницами на одном сайте. Это улучшает индексацию сайта поисковыми системами, распределяет ссылочный вес и помогает пользователям находить релевантный контент.

- Логичная навигация. Навигационное меню должно отражать структуру сайта и облегчать доступ к основным разделам и подразделам сайта. Использование хлебных крошек (breadcrumb navigation) также помогает пользователям ориентироваться на сайте.

- Анкорные ссылки. Использование релевантных и информативных анкорных текстов для внутренних ссылок помогает поисковым системам понимать контекст страницы-получателя.

- Стратегия перелинковки. Включение ссылок на связанный контент внутри страниц помогает удерживать пользователей на сайте и способствует лучшему пониманию структуры сайта поисковыми системами.

Правильное применение этих принципов архитектуры сайта и внутренней перелинковки значительно улучшает техническое SEO, облегчая поисковым системам индексацию и понимание контента сайта, а также улучшая общий пользовательский опыт.

Инструменты SEO

Инструменты SEO

Инструменты и практики для анализа и улучшения технического SEO

Инструменты и практики для анализа и улучшения технического SEO являются неотъемлемой частью оптимизации сайта для поисковых систем. Они позволяют выявлять и устранять технические проблемы, которые могут мешать индексации, краулингу и, в конечном итоге, ранжированию сайта. Вот некоторые ключевые инструменты и практики, которые используются специалистами по SEO для улучшения технического состояния сайтов:

Инструменты для анализа технического SEO:

- Google Search Console. Бесплатный инструмент от Google, который предоставляет ценную информацию о том, как поисковая система взаимодействует с вашим сайтом. Он помогает выявлять проблемы с индексацией, безопасностью сайта и предоставляет рекомендации по их устранению.

- Screaming Frog SEO Spider. Популярное настольное приложение, которое позволяет сканировать сайты и анализировать ключевые элементы на странице для выявления SEO-проблем, таких, как: неработающие ссылки, отсутствие тегов заголовков и мета-описаний.

- SEMrush Site Audit. Мощный инструмент для комплексного аудита сайта, который идентифицирует технические ошибки и предлагает рекомендации по улучшению SEO-показателей.

- Ahrefs. Инструмент анализа ссылок, который также предлагает функции аудита сайта для выявления технических проблем и оптимизации внутренней перелинковки.

- Moz Pro. Платформа для аудита сайта, отслеживания ранга, анализа ссылок и выявления SEO-проблем, которая предоставляет полезные рекомендации по улучшению видимости сайта в поисковых системах.

Практики для улучшения технического SEO:

- Регулярный аудит сайта. Проведение регулярных технических аудитов сайта помогает выявлять и устранять проблемы, которые могут негативно влиять на SEO.

- Оптимизация скорости загрузки страниц. Использование инструментов, таких как Google PageSpeed Insights, для анализа и улучшения времени загрузки страниц.

- Улучшение мобильной оптимизации. Убедитесь, что ваш сайт оптимизирован для мобильных устройств, используя адаптивный дизайн и улучшая мобильную навигацию.

- Оптимизация структуры URL. Создание чистых, логичных URL-адресов, которые легко понять как пользователям, так и поисковым системам.

- Исправление ошибок 404 и перенаправлений. Использование 301 перенаправлений для удаленных страниц и минимизация количества ошибок 404 для улучшения пользовательского опыта и эффективности краулинга.

Применение этих инструментов и практик позволит улучшить техническое SEO вашего сайта, повысить его индексацию и видимость в поисковых системах, а также обеспечить лучший пользовательский опыт.

4

4